论文解读 | 解释和利用对抗性示例

原创 | 文 BFT机器人

摘要ABSTRACT

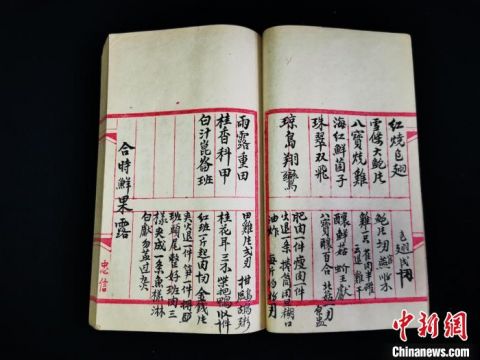

(相关资料图)

这篇论文研究了神经网络和其他机器学习模型在错误分类对抗性示例方面的问题。对抗性示例是通过对数据中的示例应用微小但故意的扰动来生成的,导致模型输出错误答案。以往的解释主要集中在非线性和过拟合上,然而,本文提出了一种不同的观点,认为神经网络易受对抗性扰动影响的主要原因是其线性特性。这个观点得到了新的定量结果的支持,同时也首次解释了这种现象的跨架构和跨训练集泛化的特点。此外,研究者基于这个观点提出了一种简单而快速的生成对抗性示例的方法。通过将这种方法应用于对抗性训练,他们在MNIST数据集上的maxout网络测试中减少了测试集误差。

01介绍

这节介绍了一个有趣的发现,即最先进的神经网络和其他机器学习模型,包括那些采用深度学习方法的,很容易受到对抗性示例的影响。对抗性示例是一种在输入数据中故意引入微小扰动,以使模型产生错误分类的现象。论文指出,这些机器学习模型在错误分类的对抗性示例与正确分类的原始示例之间的差异很小。即使是使用不同架构在不同子集上训练的模型也可能对相同的对抗性示例产生错误分类,这揭示了训练算法中的盲点。

研究者认为对抗性示例揭示了现有训练算法的局限性。虽然一些推测认为这可能是因为深度神经网络的极端非线性特性,或者模型平均和正则化等问题,但论文证明了这些假设是不必要的。事实上,高维空间中的线性行为就足以产生对抗性示例。基于这一观点,研究者提出了一种快速生成对抗性示例的方法,并且强调对抗性训练具有实用性。此外,他们指出,除了常用的正则化策略如dropout、预训练和模型平均外,对抗性训练可以提供额外的正则化好处。然而,常见的正则化方法并不能显著降低模型对对抗性示例的脆弱性,但将模型从非线性转变为类似RBF网络这样的非线性模型族可以实现这一点。

解释表明,在易于训练的线性模型与抵抗对抗性扰动的非线性模型之间存在一种紧张的平衡关系。最终,论文提出,通过设计更强大的优化方法,可以成功地训练更多的非线性模型,从而可能避免这种平衡。

02相关工作

Szegedy等人演示了神经网络和相关模型的各种有趣的特性。与本文最相关的包括:

l 盒约束L-BFGS可以可靠地找到对抗性示例。

l 在一些数据集上,如ImageNet (Deng et al ., 2009),对抗性示例与原始示例非常接近,以至于人眼无法区分差异。

l 相同的对抗性示例经常被具有不同架构的各种分类器错误分类,或者在训练数据的不同子集上进行训练。

l 浅层softmax回归模型也容易受到对抗性示例的影响

l 对抗性示例的训练可以使模型正则化——然而,由于需要在内环中进行昂贵的约束优化,这在当时是不切实际的。

这些结果表明,现代机器学习技术所构建的分类器,即使在测试集上表现出色,仍然未能真正学习决定正确输出标签的潜在概念。相反,这些算法似乎建立在一个局限的范围内,可以有效处理自然数据,但在处理概率较低的数据空间点时表现不佳。这一点尤其令人失望,因为流行的计算机视觉方法使用卷积神经网络特征来近似感知距离,而如果拥有微小感知距离的图像对应于网络表示中完全不同的类别,那么这种相似性度量显然存在缺陷。

03对抗性例子的线性解释

在许多问题中,单个输入特征的精度是有限的。例如,数字图像通常每像素只使用8位,因此它们丢弃动态范围1/255以下的所有信息。由于特征的精度是有限的,如果扰动η的每个元素都小于特征的精度,那么分类器对输入x的响应不同于对抗性输入˜x: = x + η是不合理的。形式上,对于类分离良好的问题,我们期望分类器将相同的类分配给x和,只要||η||∞小到足以被与我们的问题相关的传感器或数据存储设备丢弃。

考虑一个权向量w和一个对抗性例子˜x:之间的点积:

对抗性扰动使活化增大

这个解释表明,如果一个简单的线性模型的输入有足够的维数,它可以有对抗性的例子。先前对抗性例子的解释援引了神经网络的假设属性,例如它们假定的高度非线性性质。我们基于线性的假设更简单,也可以解释为什么softmax回归容易受到对抗性示例的影响。

04非线性模型的线性扰动

设θ为模型的参数,x为模型的输入,y为与x相关的目标(对于有目标的机器学习任务),J(θ, x, y)为用于训练神经网络的成本。

我围绕θ的当前值线性化代价函数,得到最优的最大范数约束扰动

实验证明了作者假设的对抗样本的产生原因是由于模型的线性特性。同时,这种算法也可作为一种加速对抗训练的方法。

05线性模型与权重衰减的对抗性训练

考虑的最简单的模型是逻辑回归。在这种情况下,快速梯度符号法是精确的。我们可以用这个例子来直观地了解如何在一个简单的设置中生成对抗性示例。图示见图2。

如果我们训练一个单一模型来识别标签y∈{−1,1},P (y = 1) =

其中σ(z)为logistics型函数,则训练由梯度下降组成

06深度网络的对抗性训练

通过对抗性和干净样例的混合训练,神经网络可以在一定程度上进行正则化。对抗性示例的训练与其他数据增强方案有所不同;通常,使用转换(例如预期在测试集中实际发生的翻译)来增加数据。这种形式的数据增强使用不太可能自然发生的输入,但暴露了模型概念化其决策函数的方式中的缺陷。当时,这个程序从未被证明可以在最先进的基准上提高辍学率。然而,这部分是因为很难对基于L-BFGS的昂贵对抗性示例进行广泛的实验。

我们发现基于快速梯度符号方法的对抗性目标函数训练是一种有效的正则化器:

07对抗样本泛化原因

上图表明, 通过尝试不同的ϵ值,我们发现对抗性示例出现在由快速梯度符号方法定义的1-D子空间的连续区域中,而不是在局部极值附近。这解释了为什么对抗性示例如此普遍,以及为什么一个分类器错误分类的示例被另一个分类器错误分类的概率相当高。

为了解释多个分类器将相同类别分配给对抗性示例的现象,假设使用当前方法训练的神经网络类似于在相同训练集上训练的线性分类器。即使在不同子集上训练,这个基准分类器能够学习类似的分类权重,这是机器学习算法泛化的结果。这些底层分类权重的稳定性反过来导致对抗性示例的稳定性。

作者 | 不加糖

排版 | 春花

审核 | 柒柒

若您对该文章内容有任何疑问,请于我们联系,将及时回应,想获得更多第一资讯请关注微信公众号:智能机器人研究

关键词: